INTEROPERABILIDAD, SOCKETS Y GESTIÓN DE ARCHIVOS

Interoperabilidad, Gestión de archivos y Sockets

Un recorrido completo por los pilares tecnológicos de los entornos mixtos modernos

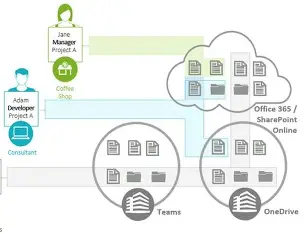

En la actualidad, las organizaciones, instituciones educativas, gobiernos y desarrolladores trabajan sobre infraestructuras tecnológicas compuestas por múltiples sistemas operativos. La necesidad de compartir recursos, comunicarse eficientemente y mantener una integración fluida entre componentes diversos es fundamental. Este artículo profundiza en tres pilares esenciales que permiten el funcionamiento eficaz de estos entornos: la interoperabilidad entre sistemas operativos, los sistemas de archivos y recursos compartidos, y la comunicación entre procesos.

|

| Sistemas operativos (Windows, Linux, macOS, Android) conectados entre sí con líneas de comunicación, representando la interoperabilidad. |

4.1 Interoperabilidad entre Sistemas Operativos

Definición

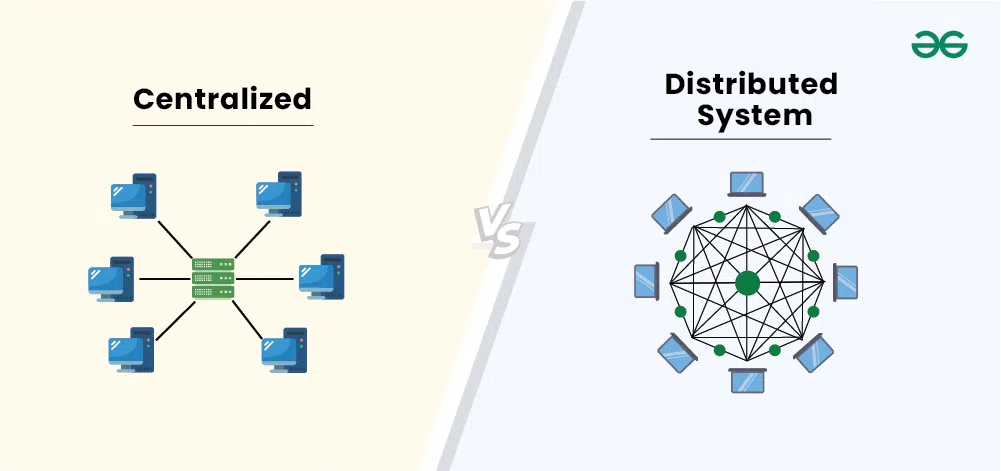

La interoperabilidad entre sistemas operativos se refiere a la capacidad de distintos entornos tecnológicos —por ejemplo, Windows, Linux, macOS, BSD o incluso Android— de colaborar entre sí, intercambiar datos, ejecutar servicios mutuamente y comunicarse a través de redes y aplicaciones. Esta capacidad es crucial para entornos empresariales y académicos modernos, donde la diversidad tecnológica es común.

La interoperabilidad no significa necesariamente que los sistemas funcionen de manera idéntica, sino que son capaces de trabajar juntos de forma coherente y productiva, utilizando estándares abiertos, protocolos de red compatibles, y herramientas de software que reducen o eliminan las barreras entre plataformas.

|

| Infografía circular mostrando Windows, Linux, macOS, BSD, Android conectados por flechas bidireccionales |

Características

Los entornos interoperables se basan en el uso de estándares abiertos como TCP/IP para comunicación, HTTP para servicios web, y SMB o NFS para intercambio de archivos. Además, utilizan herramientas que permiten ejecutar software de un sistema en otro, como máquinas virtuales (VMware, VirtualBox), contenedores (Docker, Podman), o emuladores (Wine para ejecutar aplicaciones de Windows en Linux).

Otra característica es el uso de lenguajes de programación multiplataforma como Java, Python o C++, que permiten desarrollar aplicaciones que funcionen en varios sistemas. También se integran tecnologías como LDAP para autenticar usuarios en redes mixtas, y herramientas de monitoreo y administración centralizada que trabajan en múltiples plataformas simultáneamente.

La interoperabilidad no solo se limita a compartir archivos o impresoras, también abarca la ejecución de procesos distribuidos, la integración de APIs RESTful, el acceso a bases de datos desde cualquier sistema operativo, y la gestión unificada de redes híbridas.

|

| Grid visual mostrando estándares abiertos (TCP/IP, HTTP, SMB, NFS) y herramientas (VMware, Docker, Wine) |

Funciones

Permite el trabajo colaborativo entre usuarios que usan diferentes sistemas operativos, facilita la administración y monitoreo de redes heterogéneas, permite el desarrollo de software compatible con múltiples entornos, habilita el acceso a servicios remotos, permite la integración de software nuevo con sistemas heredados, y mejora la portabilidad de aplicaciones entre distintas plataformas.

También juega un papel esencial en la migración tecnológica, permitiendo que una organización transicione de un sistema operativo a otro de forma gradual, sin necesidad de reescribir todo su software ni reemplazar su infraestructura.

|

| Diagrama de flujo mostrando usuarios con diferentes OS trabajando en el mismo proyecto |

Ventajas

Una infraestructura interoperable ofrece flexibilidad tecnológica, al permitir elegir herramientas por su funcionalidad y no por su compatibilidad. Reduce los costos, ya que se puede combinar software propietario con libre sin perder funcionalidad. Permite mantener sistemas legados mientras se integran soluciones modernas.

También mejora la continuidad del negocio, ya que no se depende de un único proveedor. Favorece la colaboración remota y descentralizada, permite usar hardware variado con los mismos servicios, y abre la puerta a modelos de computación en la nube, edge computing y soluciones híbridas sin restricciones.

|

| Iconografía moderna mostrando flexibilidad, reducción de costos, compatibilidad |

Desventajas

A pesar de sus beneficios, la interoperabilidad implica complejidad técnica. Requiere conocimiento avanzado en protocolos de red, compatibilidad de archivos, configuración de servicios compartidos y gestión de seguridad. Si no se configura adecuadamente, puede haber problemas de compatibilidad, pérdida de datos o fallos en la ejecución de servicios.

También existe el riesgo de errores de comunicación entre sistemas mal integrados, dificultades para implementar políticas de seguridad unificadas y desafíos en la administración y soporte técnico cuando se combinan múltiples sistemas operativos con distintos ciclos de vida y actualización.

|

| Ilustración mostrando múltiples capas de configuración y posibles puntos de fallo |

Áreas de aplicación

Se aplica en organizaciones que operan con múltiples sistemas operativos simultáneamente, como universidades, centros de investigación, hospitales y empresas multinacionales. También es esencial en centros de datos que prestan servicios a diversos clientes, en la industria del desarrollo de software multiplataforma, en entornos de administración pública que deben integrar sistemas nuevos con software antiguo, y en plataformas en la nube que dan servicio a usuarios con configuraciones muy variadas.

|

| Collage mostrando universidad, hospital, empresa, centro de datos |

4.2 Sistemas de Archivos y Recursos Compartidos (NFS, Impresoras)

Definición

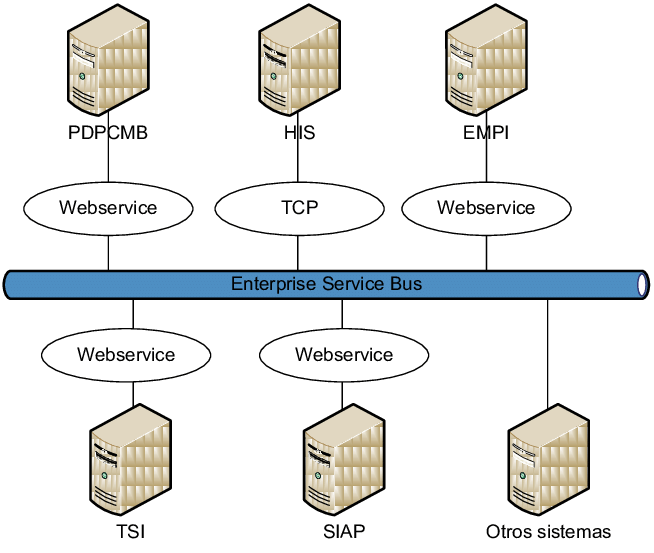

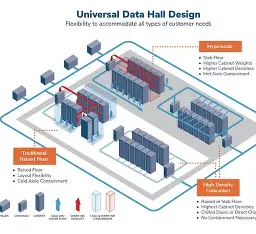

Los sistemas de archivos y recursos compartidos permiten que archivos, carpetas, unidades de almacenamiento, impresoras y otros dispositivos puedan ser utilizados desde múltiples computadoras como si se encontraran físicamente conectados a ellas. Esto se logra mediante el uso de protocolos de red especializados que hacen posible la gestión y uso remoto de estos recursos.

Protocolos como NFS (Network File System), utilizado principalmente en entornos Unix y Linux, y SMB (Server Message Block), nativo de Windows, son fundamentales para compartir carpetas o archivos en red. En el caso de dispositivos como impresoras, se utilizan protocolos como IPP (Internet Printing Protocol) o plataformas como CUPS (Common UNIX Printing System) para gestionar trabajos de impresión desde diversos equipos conectados.

|

| Diagrama simple mostrando servidor central compartiendo recursos a múltiples clientes |

Características

Estos sistemas funcionan bajo el modelo cliente-servidor. Un servidor central comparte archivos o dispositivos, y los clientes acceden a ellos a través de la red. La autenticación de usuarios, la asignación de permisos y el cifrado de datos son parte integral de este proceso.

Ofrecen capacidad de montar carpetas remotas como si fueran locales, trabajar con múltiples tipos de sistemas operativos al mismo tiempo, y ejecutar operaciones de lectura o escritura en recursos ubicados físicamente en otra máquina. Algunos sistemas permiten también sincronización de archivos en tiempo real y acceso concurrente multiusuario.

|

| Computadoras diversas, servidor CUPS, impresora, cola de trabajos |

Funciones

Permiten a los usuarios abrir, modificar y guardar documentos almacenados en un servidor remoto, como si estuvieran en su propio equipo. Posibilitan que múltiples estaciones de trabajo impriman en una sola impresora en red. Facilitan la gestión centralizada de archivos importantes, así como la aplicación de políticas de respaldo y retención de datos.

En entornos educativos o corporativos, estas funciones permiten crear carpetas compartidas por departamentos, usuarios o proyectos, agilizando la colaboración. También se usan en servidores NAS (Network Attached Storage), donde los usuarios almacenan o acceden a grandes volúmenes de información.

|

| Ilustración isométrica de oficina moderna con recursos compartidos |

Ventajas

Centralizar recursos permite reducir la duplicación de archivos y el uso innecesario de dispositivos físicos. Se simplifica la gestión, ya que las actualizaciones y respaldos pueden realizarse en un solo lugar. Mejora la colaboración, ya que múltiples usuarios pueden trabajar en los mismos documentos o proyectos. Además, se optimiza la inversión en hardware, ya que una sola impresora o disco puede ser utilizado por toda una red.

Desde el punto de vista de la seguridad, la administración centralizada permite aplicar políticas de acceso, cifrado y respaldo más efectivas que si cada usuario trabajara de manera independiente.

|

| Antes/después mostrando recursos distribuidos vs centralizados |

Desventajas

Estos sistemas dependen completamente de la red. Si el servidor o la conexión falla, los recursos no estarán disponibles. Existen riesgos de congestión si muchos usuarios acceden simultáneamente. También hay riesgo de conflicto en accesos concurrentes a los mismos archivos. La mala configuración de permisos puede exponer información sensible. Además, pueden existir problemas de compatibilidad entre sistemas operativos si no se emplean protocolos universales o adaptadores correctos.

|

| Diagrama mostrando dependencias de red y posibles fallos |

Áreas de aplicación

Se usan en oficinas corporativas que comparten recursos físicos como impresoras o carpetas de trabajo. Son comunes en centros educativos donde varios laboratorios usan el mismo sistema de archivos o almacenamiento. También son indispensables en infraestructuras de red empresarial, en sistemas de respaldo y recuperación, y en plataformas que requieren acceso a grandes volúmenes de datos compartidos.

|

| Split-screen mostrando oficina corporativa y laboratorio educativ |

4.3 Comunicación entre Procesos (Sockets, RPC)

Definición

La comunicación entre procesos, también conocida como IPC (InterProcess Communication), es el conjunto de técnicas que permiten a dos o más procesos, ya sea en el mismo equipo o distribuidos en una red, intercambiar información o coordinar acciones. Esto es esencial para el funcionamiento de aplicaciones modernas, desde sistemas operativos hasta servicios web, videojuegos o sistemas en la nube.

Los dos mecanismos más destacados son los sockets y los llamados a procedimientos remotos (RPC). Los sockets son interfaces de red que permiten enviar y recibir datos entre procesos. Los RPC permiten que un programa invoque funciones que se ejecutan en otro equipo, ocultando la complejidad de la red.

|

| Ilustración abstracta mostrando procesos comunicándose localmente y en red |

Características

La comunicación puede ser síncrona o asíncrona. Puede utilizar protocolos confiables (como TCP) o no confiables pero más rápidos (como UDP). Los sockets permiten definir direcciones IP y puertos para establecer la conexión. Los RPC pueden construirse sobre múltiples tecnologías como gRPC, JSON-RPC, XML-RPC o SOAP.

Soporta comunicación entre procesos en distintos lenguajes, siempre que haya compatibilidad de interfaz. También puede implementarse en diferentes capas del modelo OSI, lo que ofrece flexibilidad según las necesidades de la aplicación.

|

| Comparativa visual síncrona vs asíncrona, TCP vs UDP |

Funciones

Permite la construcción de aplicaciones cliente-servidor, en las que un cliente solicita datos o servicios, y un servidor responde. Habilita la ejecución remota de funciones o procedimientos, facilita la transferencia de mensajes entre procesos que cooperan para realizar tareas específicas, y permite el monitoreo en tiempo real de eventos o estados del sistema.

Los sockets son fundamentales para servicios como correo electrónico, navegación web, transmisión de video, chat y videojuegos. Los RPC son clave en el desarrollo de microservicios, APIs distribuidas, arquitecturas orientadas a servicios (SOA) y en la comunicación entre contenedores o servicios en la nube.

|

| Diagrama mostrando navegador, servidor web, base de datos |

Ventajas

Permite el desarrollo modular y distribuido de aplicaciones, facilita la escalabilidad horizontal, mejora el rendimiento al dividir tareas entre procesos, y permite a los desarrolladores construir aplicaciones complejas sobre una red sin preocuparse por los detalles de bajo nivel. Además, la reutilización de funciones a través de RPC reduce la duplicación de código.

|

| Infografía mostrando crecimiento horizontal y componentes modulares |

Desventajas

La implementación puede ser complicada. Hay que gestionar errores de red, sincronización entre procesos, seguridad, cifrado de datos y posibles pérdidas de mensajes. Las pruebas y la depuración en entornos distribuidos son difíciles. El mal diseño puede generar bloqueos, cuellos de botella o errores que afecten a múltiples componentes del sistema.

|

| Diagrama mostrando múltiples puntos de fallo y complejidad en debugging |

Áreas de aplicación

Son fundamentales en servidores web, servicios REST, microservicios, videojuegos en línea, sistemas de monitoreo, automatización industrial, IoT, plataformas en la nube, blockchain, aplicaciones móviles con backend distribuido y prácticamente cualquier aplicación moderna que dependa de la conectividad.

|

| Grid mostrando gaming online, IoT, blockchain, apps móviles, cloud |

Comentarios

Publicar un comentario